我们接着上一章节基础篇

手把手教你搭建智能工作流基础篇,n8n+Deepseek大模型保姆级教程

接着聊,在基础篇中认识了AI核心节点“AI Agent”以及它下面的Memory和Tool两个插座子节点,知道它们的作用和优缺点以及使用场景,讲解了如何将Deepseek API对接到“AI Agent”插槽上,除了这个方法还有另外一个方法也能将其他AI模型API对接到“AI Agent”插槽上,不止是Deepseek包括目前所有平台对外提供的AI API,包括国内的字节豆包、阿里通义千问、讯飞星火、百度文心一言等等。由于知识点太多,篇幅不宜过长,将“AI Agent”配置和其他AI对接的方法放在本章进阶篇中详细给大家介绍。

连接Deepseek的另一种方法

没错,基础篇中我们其实是通过欺骗OpenAI Chat model节点达到成功访问调用Deepseek的目的,对!原因我们知道了,Deepseek调用接口99%兼容ChatGPT的API,所以使用OpenAI Chat model节点一样可以调用Deepseek,没错只要兼容ChatGPT API的其他AI都可以使用OpenAI Chat model节点。

使用HTTP Request 节点可以接入所有AI大模型,因为API是一种开放的Web调用接口,我们可以使用 HTTP Request 节点对任何提供AI API的公司或者云平台发起请求URL调用,请求必要的参数我们就直接在HTTP Request 节点中设置就可以了。需要注意的是,使用 HTTP Request 调用模型较为复杂,另外一个则是如果我们使用 HTTP Request,就无法使用 n8n 内置的 LangChain 节点了。因为 HTTP Request 是无法作为子节点挂在 LangChain 节点下方的,这会让 工作流 的编排难度大幅度提升,也限制了 n8n 在 AI 领域的发挥。 为此,推荐欺骗OpenAI Chat model节点方法,可以将国产大模型的 API 转换为 OpenAI API 接入 n8n。

步骤1: 将HTTP Request 节点拖拽到画布上

搜索HTTP Request 节点

拖拽到画布,双击打开HTTP Request 节点面板。

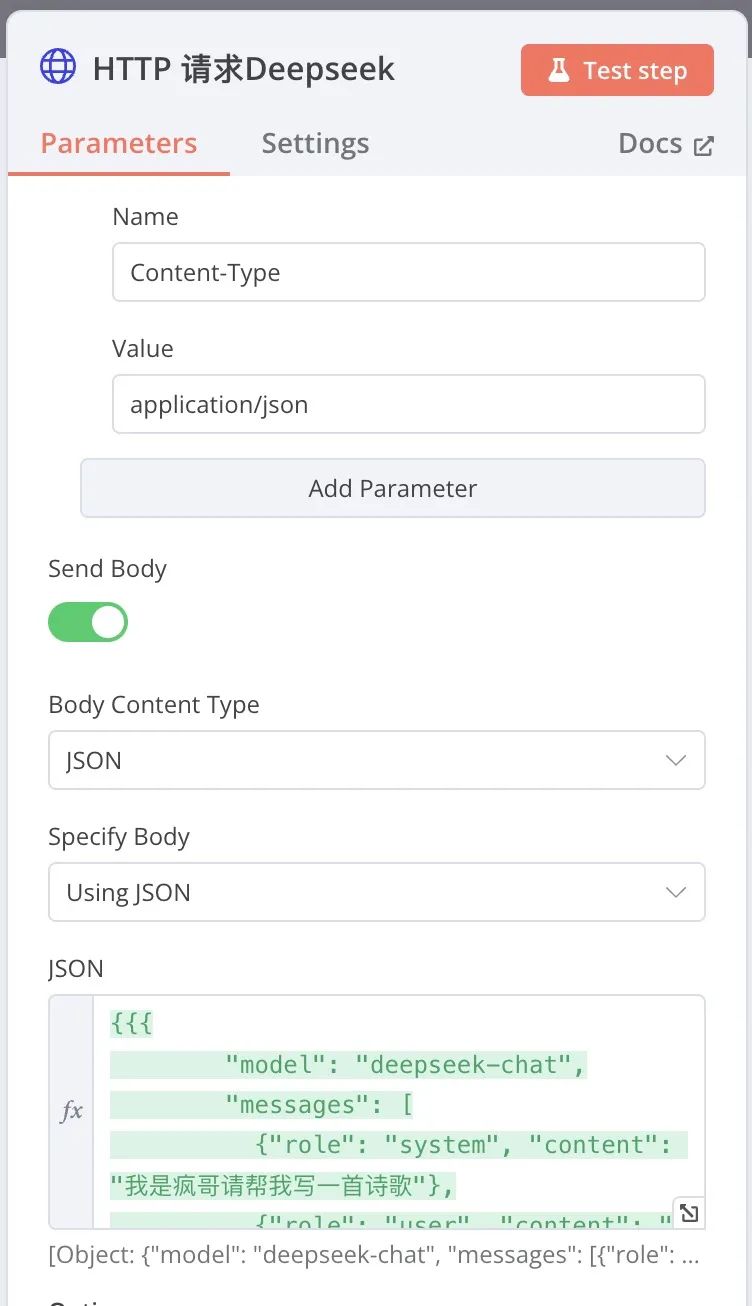

步骤2: 配置 HTTP Request 节点API参数

双击打开,开始参数配置。

HTTP Request 节点在成功运行之前,左边的数据输入和右边的数据输出都是空的,我们开始配置请求参数:

请求方法

Method :POST

Deepseek API的网址

URL:https://api.siliconflow.cn/v1/chat/completions

请求头开关

Send Headers:打开

请求参数

Header Parameters:

- Name:Authorizations

填入你的Deepseek API-Key,与前面的“Bearer”隔一个空格

- Value:Bearer sk-4f7e92150feb4368bd677bfb6f338330

- Name:Content-Type

- Value:application/json

Body请求开关

Send Body:打开

- Body Content Type:Json

- Specify Body:Using Json

选择[removed]表达式),我们输入带{{}}的Json,"Fixed"只能输入纯文本。

- JSON:expression

{{{

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "我是疯哥请帮我写一首诗歌"},

{"role": "user", "content": "Hello!"}

],

"stream": false

} }}

在n8n中使用[removed]表达式)必须将实际内容包在两个{{ }}(花括号)里面,我们解读一下实际请求的json中的信息:

"model": "deepseek-chat"

请求Deepseek模型名称,必填,默认是"deepseek-chat"。

"messages": [

{"role": "system", "content": "我是疯哥请帮我写一首诗歌"},

{"role": "user", "content": "Hello!"}

],

发给Deepseek的请求参数,一个是"role"角色,一个是"content"对话内容。

"messages"是个数组,表示我们可以设置多个"role"和"content"组合对,用中括号[ ]包起来。

Json框右下角的放大按钮,方便我们在大框中编辑Json,如下图:

完整看一下所有配置的截图:

步骤3: Deepseek API 调用测试

点击“Test Step”运行HTTP Request 节点,如果配置正确的话我们将看到HTTP Request 节点右边会显示Deepseek回答我们的结果。

到此为止,HTTP Request 节点为我们成功获取了Deepseek返回的结果,非常好。现在,你可以依葫芦画瓢利用HTTP Request 节点请求所有大模型的API。

配置AI Agent 提示词

在基础篇中介绍了AI Agent的作用和相关知识,并没有实际演示如何与Open Chat Model节点对接,我们的提示词需要在AI Agent中配置,现在开始。

步骤1: Deepseek Chat Model 节点连接 AI Agent

首先,要把欺骗OpenAI Chat model节点连接到AI AIgent上,哈。

步骤2: 在HTTP Request 节点上配置API参数

双击AI AIgent开始配置参数。

代理方式

Agnet :Tools Agent

提示词方式

Prompt:Define below

输入提示词,选择[removed]表达式)

Text:Expression

这里要注意,我们还没有运行工作流,没有输入数据,也就是还没有开始抓取AI新闻,所以我们先抓取新闻,有了数据才可以在抓取的数据基础上编辑我们提示词表达式。

步骤3: 运行工作流

点击“Test workflow”,把我们的工作流跑一下,获取新闻数据。

完成后,我们双击AI Agent节点,查看结果,并设置我们的提示词。左边是抓取到的新闻列表,我们先将提示词写到Text框中,也可以选择[removed]表达式)输入提示词。

图方便就用鼠标拖拽,也可以在上面打框里手动输入表达式,这里关键的一点就是我们的提示词在哪里?

要喂给Deepseek的提示词直接写在表达式框里,Deepseek会根据你的提示词输出结果。

需要注意的是Deepseek默认输出的内容格式是带换行符的Makedown格式,这个格式在网页上显示的时候是自带样式格式的方便用户浏览。如果你不需要Makedown格式可以后续进一步对其修改,这里就不细说了。

后续扩展,既然我们成功抓取了新闻内容,又成功让Deepseek按照我们的要求对新闻进行了处理,这个处理结果后续怎么使用就非常灵活多变了,看你有什么样的需求,我们可以在AI Agent节点后面继续添加其他工作流节点,比如直接输出PDF、图片海报、发送到某人邮箱,保存到数据库通过网站提供给用户浏览等等,非常多的场景可以想象。

结语:n8n允许我们在官方没有提供对应适配节点的情况下手动适配需要的功能。

相较于Coze这类全封装的在线服务式工作流平台,n8n的显著优势之一在于其半开放式节点的设计。这些节点为用户提供了在官方适配节点缺失时,手动调整和实现特定功能的灵活性。在n8n中,Code节点和HTTP Request节点是这类半开放式节点中最常用的两个,它们为用户提供了强大的自定义能力,以满足各种复杂的工作流程需求。

发表评论 取消回复